DAS, SAN, NAS - магические аббревиатуры, без которых не обходится ни одна из статей и ни одно аналитическое исследование по системам хранения. Они служат обозначением основных типов соединения систем хранения с вычислительными системами.

DAS (direct-attached storage) - устройство внешней памяти, напрямую подсоединенное к основному компьютеру и используемое только им. Простейший пример DAS - встроенный жесткий диск. Для связи хоста с внешней памятью в типовой конфигурации DAS используется SCSI, команды которого позволяют выделить определенный блок данных на специфицированном диске или смонтировать определенный картридж в ленточной библиотеке.

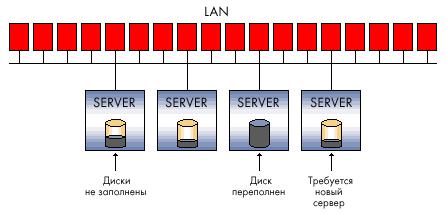

Конфигурация DAS приемлема для применений, нетребовательных к объемам, производительности и надежности систем хранения. DAS не обеспечивает возможности совместного использования емкости хранения разными хостами и тем более возможности разделения данных. Установка таких устройств хранения - более дешевый вариант по сравнению с сетевыми конфигурациями, однако, если иметь в виду большие организации, этот тип инфраструктуры хранения нельзя считать оптимальным. Много DAS-подключений означает разрозненные и разбросанные по всей компании островки внешней памяти, избытки которой не могут использоваться другими хост-компьютерами, что приводит к неэффективной трате емкости хранения в целом.

Кроме того, при такой организации хранения нет никакой возможности создать единую точку управления внешней памятью, что неизбежно усложняет процессы резервирования/восстановления данных и создает серьезную проблему защиты информации. В итоге общая стоимость владения подобной системой хранения может оказаться значительно выше, чем более сложная на первый взгляд и изначально более дорогая сетевая конфигурация.

SAN

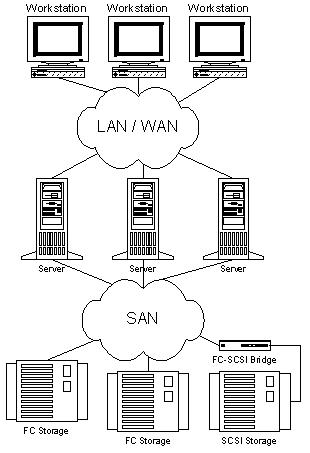

Сегодня, говоря о системе хранения корпоративного уровня, мы имеем в виду сетевое хранение (storage networking). Больше известны широкой публике сети хранения - SAN (storage area network). SAN представляет собой выделенную сеть устройств хранения, которая позволяет множеству серверов использовать совокупный ресурс внешней памяти без нагрузки на локальную сеть.

SAN не зависит от среды передачи, но на данный момент фактическим стандартом является технология Fibre Channel (FC), обеспечивающая скорость передачи данных 1-2 Гбит/с. В отличие от традиционных сред передачи на базе SCSI, обеспечивающих подключение на расстояние не более чем на 25 метров, Fibre Channel позволяет работать на удалении до 100 км. Средой передачи в сети Fibre Channel могут служить как медный кабель, так и оптоволокно.

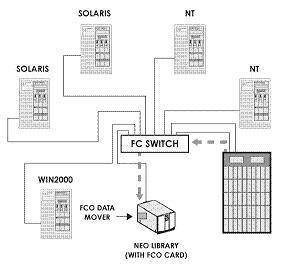

В сеть хранения могут подключаться дисковые массивы RAID, простые массивы дисков, (так называемые Just a Bunch of Disks - JBOD), ленточные или магнитооптические библиотеки для резервирования и архивирования данных. Основными компонентами для организации сети SAN помимо самих устройств хранения являются адаптеры для подключения серверов к сети Fibre Channel (host bus adapter - НВА), cетевые устройства для поддержки той или иной топологии FC-сети и специализированный программный инструментарий для управления сетью хранения. Эти программные системы могут выполняться как на сервере общего назначения, так и на самих устройствах хранения, хотя иногда часть функций выносится на специализированный тонкий сервер для управления сетью хранения (SAN appliance).

Задача программного обеспечения для SAN - это прежде всего централизованное управление сетью хранения, включая конфигурирование, мониторинг, контроль и анализ компонентов сети. Одной из наиболее важных является функция управления доступом к дисковым массивам, если в SAN хранятся данные разнородных серверов. Сети хранения обеспечивают одновременный доступ множества серверов к множеству дисковых подсистем, привязывая каждый хост к определенным дискам на определенном дисковом массиве. Для разных операционных систем необходимо расслоение дискового массива на «логические области» (logical unit - LUN), которыми они будут пользоваться без возникновения конфликтов. Выделение логических областей может понадобиться и для организации доступа к одним и тем же данным для некоторого пула серверов, например, серверов одной рабочей группы. За поддержку всех этих операций отвечают специальные программные модули.

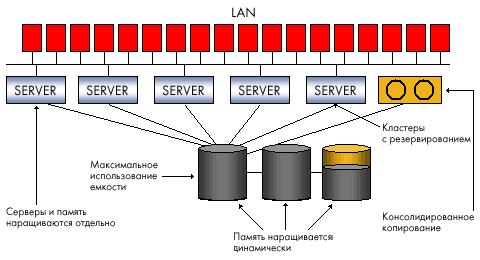

Привлекательность сетей хранения объясняется теми преимуществами, которые они могут дать организациям, требовательным к эффективности работы с большими объемами данных. Выделенная сеть хранения разгружает основную (локальную или глобальную) сеть вычислительных серверов и клиентских рабочих станций, освобождая ее от потоков ввода/вывода данных.

Этот фактор, а также высокоскоростная среда передачи, используемая для SAN, обеспечивают повышение производительности процессов обмена данными с внешними системами хранения. SAN означает консолидацию систем хранения, создание на разных носителях единого пула ресурсов, который будет разделяться всеми вычислительными мощностями, и в результате необходимую емкость внешней памяти можно будет обеспечить меньшим числом подсистем. В SAN резервирование данных с дисковых подсистем на ленты происходит вне локальной сети и потому становится более производительным - одна ленточная библиотека может служить для резервирования данных с нескольких дисковых подсистем. Кроме того, при поддержке соответствующего ПО можно реализовать прямое резервирование в SAN без участия сервера, тем самым, разгружая процессор. Возможность разнесения серверов и памяти на большие расстояния отвечает потребностям повышения надежности корпоративных хранилищ данных. Консолидированное хранение данных в SAN лучше масштабируется, поскольку позволяет наращивать емкость хранения независимо от серверов и без прерывания их работы. Наконец, SAN дает возможность централизованного управления единым пулом внешней памяти, что упрощает администрирование.

Безусловно, сети хранения, недешевое и непростое решение и, несмотря на то, что все ведущие поставщики выпускают сегодня устройства для SAN на базе Fibre Channel, их совместимость не гарантируется, и выбор подходящего оборудования создает проблему для пользователей. Понадобятся дополнительные расходы на организацию выделенной сети и покупку управляющего ПО, и начальная стоимость SAN окажется выше организации хранения с помощью DAS, однако совокупная стоимость владения должна быть ниже.

NAS

В отличие от SAN, NAS (network attached storage) - не сеть, а сетевое устройство хранения, точнее, выделенный файловый сервер с подсоединенной к нему дисковой подсистемой. Иногда в конфигурацию NAS может входить оптическая или ленточная библиотека. NAS-устройство (NAS appliance) напрямую подключается в сеть и предоставляет хостам доступ к файлам на своей интегрированной подсистеме внешней памяти. Появление выделенных файловых серверов связано с разработкой в начале 90-х годов компанией Sun Microsystems сетевой файловой системы NFS, которая позволяла клиентским компьютерам в локальной сети использовать файлы на удаленном сервере. Затем у Microsoft появилась аналогичная система для среды Windows - Common Internet File System. Конфигурации NAS поддерживают обе эти системы, а также другие протоколы на базе IP, обеспечивая разделение файлов клиентскими приложениями.

NAS-устройство напоминает конфигурацию DAS, но принципиально отличается от нее тем, что обеспечивает доступ на уровне файлов, а не блоков данных, и позволяет всем приложениям в сети совместно использовать файлы на своих дисках. NAS специфицирует файл в файловой системе, сдвиг в этом файле (который представляется как последовательность байт) и число байт, которое необходимо прочитать или записать. Запрос к NAS-устройству не определяет том или сектор на диске, где находится файл. Задача операционной системы NAS-устройства транслировать обращение к конкретному файлу в запрос на уровне блоков данных. Файловый доступ и возможность разделения информации удобны для приложений, которые должны обслуживать множество пользователей одновременно, но не требуют загрузки очень больших объемов данных по каждому запросу. Поэтому обычной практикой становится использование NAS для Internet-приложений, Web-cлужб или CAПР, в которых над одним проектом работают сотни специалистов.

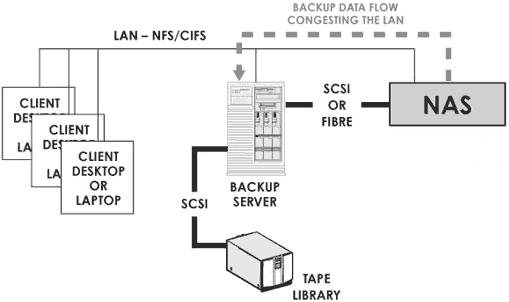

Вариант NAS прост в установке и управлении. В отличие от сети хранения, установка NAS-устройства не требует специального планирования и затрат на дополнительное управляющее ПО - достаточно просто подключить файловый сервер в локальную сеть. NAS освобождает серверы в сети от задач управления хранением, но не разгружает сетевой трафик, поскольку обмен данными между серверами общего назначения и NAS идет по той же локальной сети. На NAS-устройстве может быть сконфигурирована одна или несколько файловых систем, каждой из которых отводится определенный набор томов на диске. Всем пользователям одной и той же файловой системы по требованию выделяется некоторое дисковое пространство. Таким образом, NAS обеспечивает более эффективные по сравнению с DAS организацию и использование ресурсов памяти, поскольку подключенная напрямую подсистема хранения обслуживает только один вычислительный ресурс, и может случиться так, что у одного сервера в локальной сети будет слишком много внешней памяти, в то время как другой испытывает нехватку пространства на дисках. Но из нескольких NAS-устройств нельзя создать единый пул ресурсов хранения и потому увеличение числа NAS-узлов в сети усложнит задачу управления.

NAS + SAN = ?

Какую из форм инфраструктуры хранения выбрать: NAS или SAN? Ответ зависит от возможностей и потребностей организации, однако сравнивать или тем более противопоставлять их в принципе неверно, поскольку эти две конфигурации решают разные задачи. Файловый доступ и совместное использование информации для приложений на разнородных серверных платформах в локальной сети - это NAS. Высокопроизводительный блоковый доступ к базам данных, консолидация хранения, гарантирующая его надежность и эффективность - это SAN. В жизни, правда, все сложнее. NAS и SAN часто уже сосуществуют или должны быть одновременно реализованы в распределенной ИТ-инфраструктуре компании. Это неизбежно порождает проблемы управления и оптимального использования ресурсов хранения.

Сегодня производители ищут пути объединения обеих технологий в единую сетевую инфраструктуру хранения, которая обеспечит консолидацию данных, централизацию резервного копирования, упростит общее администрирование, масштабируемость и защиту данных. Конвергенция NAS и SAN - одна из самых важных тенденций последнего времени.

Сеть хранения позволяет создать единый пул ресурсов памяти и выделять на физическом уровне необходимую квоту дискового пространства каждому из хостов, подключенных к SAN. NAS-сервер обеспечивает разделение данных в файловой системе приложениями на разных операционных платформах, решая проблемы интерпретации структуры файловой системы, синхронизации и контроля доступа к одним и тем же данным. Поэтому, если мы хотим добавить в сеть хранения возможность разделения не только физических дисков, но и логической структуры файловых систем, нам необходим промежуточный управляющий сервер для реализации всех функций сетевых протоколов обработки запросов на уровне файлов. Отсюда общий подход к объединению SAN и NAS с помощью NAS-устройства без интегрированной дисковой подсистемы, но с возможностью подключения компонентов сети хранения. Такие устройства, которые у одних производителей называются NAS-шлюзами, у других головными NAS-устройствами, становятся своеобразным буфером между локальной сетью и SAN, обеспечивая доступ к данным в SAN на уровне файлов и разделение информации в сети хранения.

Резюме

Построение единых сетевых систем, объединяющих возможности SAN и NAS, - лишь один из шагов в направлении глобальной интеграции корпоративных систем хранения. Дисковые массивы, подключенные напрямую к отдельным серверам, перестали удовлетворять потребностям больших организаций с сложными распределенными ИТ-инфраструктурами. Сегодня просто сети хранения на основе высокопроизводительной, но специализированной технологии Fibre Channel рассматриваются не только как прорыв, но и как источник головной боли из-за сложности инсталляции, проблем с поддержкой оборудования и ПО от разных поставщиков. Однако то, что ресурсы хранения должны быть едиными и сетевыми, сомнения уже не вызывает. Ищутся пути оптимальной консолидации. Отсюда и активизация производителей решений, поддерживающих различные варианты переноса сетей хранения на IP-протокол]. Отсюда и большой интерес к различным реализациям концепции виртуализации хранения. Ведущие игроки рынка систем хранения не просто объединяют все свои продукты под общей «шапкой» (TotalStorage у IBM или SureStore у НР), но формулируют собственные стратегии создания консолидированных, сетевых инфраструктур хранения и защиты корпоративных данных. Ключевую роль в этих стратегиях будет играть идея виртуализации, поддержанная главным образом на уровне мощных программных решений централизованного управления распределенными хранилищами. В таких инициативах, как StorageTank от IBM, Federated Storage Area Management от НР, E-Infrostructure от ЕМС, программное обеспечение играет решающую роль.

И прочего, среды передачи данных и подключенных к ней серверов. Обычно используется достаточно крупными компаниями, имеющими развитую IT инфраструктуру, для надежного хранения данных и скоростного доступа к ним.

Упрощенно, СХД — это система, позволяющая раздавать серверам надежные быстрые диски изменяемой емкости с разных устройств хранения данных.

Немного теории.

Сервер к хранилищу данных можно подключить несколькими способами.

Первый и самый простой — DAS, Direct Attached Storage (прямое подключение), без затей ставим диски в сервер, или массив в адаптер сервера — и получаем много гигабайт дискового пространства со сравнительно быстрым доступом, и при использовании RAID-массива — достаточную надежность, хотя копья на тему надежности ломают уже давно.

Однако такое использование дискового пространства не оптимально — на одном сервере место кончается, на другом его еще много. Решение этой проблемы — NAS, Network Attached Storage (хранилище, подключенное по сети). Однако при всех преимуществах этого решения — гибкости и централизованного управления — есть один существенный недостаток — скорость доступа, еще не во всех организациях внедрена сеть 10 гигабит. И мы подходим к сети хранения данных.

Главное отличие SAN от NAS (помимо порядка букв в аббревиатурах) — это то, каким образом видятся подключаемые ресурсы на сервере. Если в NAS ресурсы подключаются протоколам NFS или SMB , в SAN мы получаем подключение к диску, с которым можем работать на уровне операций блочного ввода-вывода, что гораздо быстрее сетевого подключения (плюс контроллер массива с большим кэшем добавляет скорости на многих операциях).

Используя SAN, мы сочетаем преимущества DAS — скорость и простоту, и NAS — гибкость и управляемость. Плюс получаем возможность масштабирования систем хранения до тех пор, пока хватает денег, параллельно убивая одним выстрелом еще несколько зайцев, которых сразу не видно:

* снимаем ограничения на дальность подключения SCSI -устройств, которые обычно ограничены проводом в 12 метров,

* уменьшаем время резервного копирования,

* можем грузиться с SAN,

* в случае отказа от NAS разгружаем сеть,

* получаем большую скорость ввода-вывода за счет оптимизации на стороне системы хранения,

* получаем возможность подключать несколько серверов к одному ресурсу, это нам дает следующих двух зайцев:

- на полную используем возможности VMWare — например VMotion (миграцию виртуальной машины между физическими) и иже с ними,

- можем строить отказоустойчивые кластеры и организовывать территориально распределенные сети.

Что это дает?

Помимо освоения бюджета оптимизации системы хранения данных, мы получаем, вдобавок к тому что я написал выше:

* увеличение производительности, балансировку нагрузки и высокую доступность систем хранения за счет нескольких путей доступа к массивам;

* экономию на дисках за счет оптимизации расположения информации;

* ускоренное восстановление после сбоев — можно создать временные ресурсы, развернуть на них backup и подключить к ним сервера, а самим без спешки восстанавливать информацию, или перекинуть ресурсы на другие сервера и спокойно разбираться с умершим железом;

* уменьшение время резервного копирования — благодаря высокой скорости передачи можно бэкапиться на ленточную библиотеку быстрее, или вообще сделать snapshot (мгновенный снимок) с файловой системы и спокойно архивировать его;

* дисковое место по требованию — когда нам нужно — всегда можно добавить пару полок в систему хранения данных.

* уменьшаем стоимость хранения мегабайта информации — естественно, есть определенный порог, с которого эти системы рентабельны.

* надежное место для хранения mission critical и business critical данных (без которых организация не может существовать и нормально работать).

* отдельно хочу упомянуть VMWare — полностью все фишки вроде миграции виртуальных машин с сервера на сервер и прочих вкусностей доступны только на SAN.

Из чего это состоит?

Как я писал выше — СХД состоит из устройств хранения, среды передачи и подключенных серверов. Рассмотрим по порядку:

Системы хранения данных обычно состоят из жестких дисков и контроллеров, в уважающей себя системе как правило всего по 2 — по 2 контроллера, по 2 пути к каждому диску, по 2 интерфейса, по 2 блока питания, по 2 администратора. Из наиболее уважаемых производителей систем следует упомянуть HP, IBM, EMC и Hitachi. Тут процитирую одного представителя EMC на семинаре — «Компания HP делает отличные принтеры. Вот пусть она их и делает!» Подозреваю, что в HP тоже очень любят EMC. Конкуренция между производителями нешуточная, впрочем, как и везде. Последствия конкуренции — иногда вменяемые цены за мегабайт системы хранения и проблемы с совместимостью и поддержкой стандартов конкурентов, особенно у старого оборудования.

Среда передачи данных .

Обычно SAN строят на оптике, это дает на текущий момент скорость в 4, местами в 8 гигабит на канал. При построении раньше использовались специализированные хабы, сейчас больше свитчи, в основном от Qlogic, Brocade, McData и Cisco (последние два на площадках не видел ни разу). Кабели используются традиционные для оптических сетей — одномодовые и многомодовые , одномодовые более дальнобойные.

Внутри используется FCP — Fibre Channel Protocol , транспортный протокол. Как правило внутри него бегает классический SCSI, а FCP обеспечивает адресацию и доставку. Есть вариант с подключением по обычной сети и iSCSI , но он обычно использует (и сильно грузит) локальную, а не выделенную под передачу данных сеть, и требует адаптеров с поддержкой iSCSI, ну и скорость помедленнее, чем по оптике.

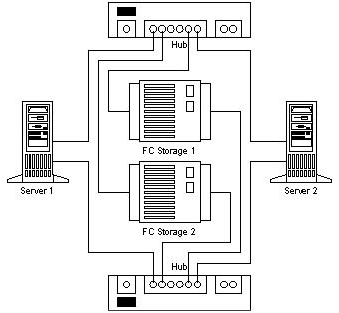

Есть еще умное слово топология, которое встречается во всех учебниках по SAN. Топологий несколько, простейший вариант — точка-точка (point to point), соединяем между собой 2 системы. Это не DAS, а сферический конь в вакууме простейший вариант SAN. Дальше идет управляемая петля (FC-AL), она работает по принципу «передай дальше» — передатчик каждого устройства соединен с приемником последующего, устройства замкнуты в кольцо. Длинные цепочки имеют свойство долго инициализироваться.

Ну и заключительный вариант — коммутируемая структура (Fabric), она создается с помощью свитчей. Структура подключений строится в зависимости от количества подключаемых портов, как и при построении локальной сети. Основной принцип построения — все пути и связи дублируются. Это значит, что до каждого устройства в сети есть минимум 2 разных пути. Здесь тоже употребимо слово топология , в смысле организации схемы подключений устройств и соединения свитчей. При этом как правило свитчи настраиваются так, что сервера не видят ничего, кроме предназначенных им ресурсов. Это достигается за счет создания виртуальных сетей и называется зонированием, ближайшая аналогия — VLAN . Каждому устройству в сети присваивается аналог MAC -адреса в сети Ethernet, он называется WWN — World Wide Name . Он присваивается каждому интерфейсу и каждому ресурсу (LUN) систем хранения данных. Массивы и свитчи умеют разграничивать доступ по WWN для серверов.

Сервера подключают к СХД через HBA - Host Bus Adapter -ы. По аналогии с сетевыми картами существуют одно-, двух-, четырехпортовые адаптеры. Лучшие "собаководы" рекомендуют ставить по 2 адаптера на сервер, это позволяет как осуществлять балансировку нагрузки, так и обеспечивает надежность.

А дальше на системах хранения нарезаются ресурсы, они же диски (LUN) для каждого сервера и оставляется место в запас, все включается, установщики системы прописывают топологию, ловят глюки в настройке свитчей и доступа, все запускается и все живут долго и счастливо*.

Я специально не касаюсь разных типов портов в оптической сети, кому надо — тот и так знает или прочитает, кому не надо — только голову забивать. Но как обычно, при неверно установленном типе порта ничего работать не будет.

Из опыта.

Обычно при создании SAN заказывают массивы с несколькими типами дисков: FC для скоростных приложений, и SATA или SAS для не очень быстрых. Таким образом получаются 2 дисковые группы с различной стоимостью мегабайта — дорогая и быстрая, и медленная и печальная дешевая. На быструю вешаются обычно все базы данных и прочие приложения с активным и быстрым вводом-выводом, на медленную — файловые ресурсы и все остальное.

Если SAN создается с нуля — имеет смысл строить ее на основе решений от одного производителя. Дело в том, что, несмотря на заявленное соответствие стандартам, существуют подводные грабли проблемы совместимости оборудования, и не факт, что часть оборудования будет работать друг с другом без плясок с бубном и консультаций с производителями. Обычно для утряски таких проблем проще позвать интегратора и дать ему денег, чем общаться с переводящими друг на друга стрелки производителями.

Если SAN создается на базе существующей инфраструктуры — все может быть сложно, особенно если есть старые SCSI массивы и зоопарк старой техники от разных производителей. В этом случае имеет смысл звать на помощь страшного зверя интегратора, который будет распутывать проблемы совместимости и наживать третью виллу на Канарах.

Часто при создании СХД фирмы не заказывают поддержку системы производителем. Обычно это оправдано, если у фирмы есть штат грамотных компетентных админов (которые уже 100 раз назвали меня чайником) и изрядный капитал, позволяющий закупить запасные комплектующие в потребных количествах. Однако компетентных админов обычно переманивают интеграторы (сам видел), а денег на закупку не выделяют, и после сбоев начинается цирк с криками «Всех уволю!» вместо звонка в саппорт и приезда инженера с запасной деталью.

Поддержка обычно сводится к замене умерших дисков и контроллеров, ну и к добавлению в систему полок с дисками и новых серверов. Много хлопот бывает после внезапной профилактики системы силами местных специалистов, особенно после полного останова и разборки-сборки системы (и такое бывает).

Про VMWare. Насколько я знаю (спецы по виртуализации поправьте меня), только у VMWare и Hyper-V есть функционал, позволяющий «на лету» перекидывать виртуальные машины между физическими серверами. И для его реализации требуется, чтобы все сервера, между которыми перемещается виртуальная машина, были подсоединены к одному диску.

Про кластеры. Аналогично случаю с VMWare, известные мне системы построения отказоустойчивых кластеров (Sun Cluster, Veritas Cluster Server) — требуют подключенного ко всем системам хранилища.

Пока писал статью — у меня спросили — в какие RAIDы обычно объединяют диски?

В моей практике обычно делали или по RAID 1+0 на каждую дисковую полку с FC дисками, оставляя 1 запасной диск (Hot Spare) и нарезали из этого куска LUN-ы под задачи, или делали RAID5 из медленных дисков, опять же оставляя 1 диск на замену. Но тут вопрос сложный, и обычно способ организации дисков в массиве выбирается под каждую ситуацию и обосновывается. Та же EMC например идет еще дальше, и у них есть дополнительная настройка массива под приложения, работающие с ним (например под OLTP, OLAP). С остальными вендорами я так глубоко не копал, но догадываюсь, что тонкая настройка есть у каждого.

* до первого серьезного сбоя, после него обычно покупается поддержка у производителя или поставщика системы.

Именно информация является движущей силой современного бизнеса и в настоящий момент считается наиболее ценным стратегическим активом любого предприятия. Объем информации растет в геометрической прогрессии вместе с ростом глобальных сетей и развитием электронной коммерции. Для достижения успеха в информационной войне необходимо обладать эффективной стратегией хранения, защиты, совместного доступа и управления самым важным цифровым имуществом - данными - как сегодня, так и в ближайшем будущем.

Управление ресурсами хранения данных стало одной из самых животрепещущих стратегических проблем, стоящих перед сотрудниками отделов информационных технологий. Вследствие развития Интернета и коренных изменений в процессах бизнеса информация накапливается с невиданной скоростью. Кроме насущной проблемы обеспечения возможности постоянного увеличения объема хранимой информации, не менее остро на повестке дня стоит и проблема обеспечения надежности хранения данных и постоянного доступа к информации. Для многих компаний формула доступа к данным «24 часа в сутки, 7 дней в неделю, 365 дней в году» стала нормой жизни.

В случае отдельного ПК под системой хранения данных (СХД) можно понимать отдельный внутренний жесткий диск или систему дисков. Если же речь заходит о корпоративной СХД, то традиционно можно выделить три технологии организации хранения данных: Direct Attached Storage (DAS), Network Attach Storage (NAS) и Storage Area Network (SAN).

Direct Attached Storage (DAS)

Технология DAS подразумевает прямое (непосредственное) подключение накопителей к серверу или к ПК. При этом накопители (жесткие диски, ленточные накопители) могут быть как внутренними, так и внешними. Простейший случай DAS-системы - это один диск внутри сервера или ПК. Кроме того, к DAS-системе можно отнести и организацию внутреннего RAID-массива дисков с использованием RAID-контроллера.

Стоит отметить, что, несмотря на формальную возможность использования термина DAS-системы по отношению к одиночному диску или к внутреннему массиву дисков, под DAS-системой принято понимать внешнюю стойку или корзину с дисками, которую можно рассматривать как автономную СХД (рис. 1). Кроме независимого питания, такие автономные DAS-системы имеют специализированный контроллер (процессор) для управления массивом накопителей. К примеру, в качестве такого контроллера может выступать RAID-контроллер с возможностью организации RAID-массивов различных уровней.

Рис. 1. Пример DAS-системы хранения данных

Следует отметить, что автономные DAS-системы могут иметь несколько внешних каналов ввода-вывода, что обеспечивает возможность подключения к DAS-системе нескольких компьютеров одновременно.

В качестве интерфейсов для подключения накопителей (внутренних или внешних) в технологии DAS могут выступать интерфейсы SCSI (Small Computer Systems Interface), SATA, PATA и Fibre Channel. Если интерфейсы SCSI, SATA и PATA используются преимущественно для подключения внутренних накопителей, то интерфейс Fibre Channel применяется исключительно для подключения внешних накопителей и автономных СХД. Преимущество интерфейса Fibre Channel заключается в данном случае в том, что он не имеет жесткого ограничения по длине и может использоваться в том случае, когда сервер или ПК, подключаемый к DAS-системе, находится на значительном расстоянии от нее. Интерфейсы SCSI и SATA также могут использоваться для подключения внешних СХД (в этом случае интерфейс SATA называют eSATA), однако данные интерфейсы имеют строгое ограничение по максимальной длине кабеля, соединяющего DAS-систему и подключаемый сервер.

К основным преимуществам DAS-систем можно отнести их низкую стоимость (в сравнении с другими решениями СХД), простоту развертывания и администрирования, а также высокую скорость обмена данными между системой хранения и сервером. Собственно, именно благодаря этому они завоевали большую популярность в сегменте малых офисов и небольших корпоративных сетей. В то же время DAS-системы имеют и свои недостатки, к которым можно отнести слабую управляемость и неоптимальную утилизацию ресурсов, поскольку каждая DAS-система требует подключения выделенного сервера.

В настоящее время DAS-системы занимают лидирующее положение, однако доля продаж этих систем постоянно уменьшается. На смену DAS-системам постепенно приходят либо универсальные решения с возможностью плавной миграции с NAS-системам, либо системы, предусматривающие возможность их использования как в качестве DAS-, так и NAS- и даже SAN-систем.

Системы DAS следует использовать при необходимости увеличения дискового пространства одного сервера и вынесения его за корпус. Также DAS-системы можно рекомендовать к применению для рабочих станций, обрабатывающих большие объемы информации (например, для станций нелинейного видеомонтажа).

Network Attached Storage (NAS)

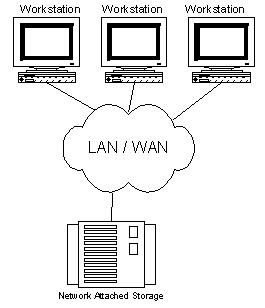

NAS-системы - это сетевые системы хранения данных, непосредственно подключаемые к сети точно так же, как и сетевой принт-сервер, маршрутизатор или любое другое сетевое устройство (рис. 2). Фактически NAS-системы представляют собой эволюцию файл-серверов: разница между традиционным файл-сервером и NAS-устройством примерно такая же, как между аппаратным сетевым маршрутизатором и программным маршрутизатором на основе выделенного сервера.

Рис. 2. Пример NAS-системы хранения данных

Для того чтобы понять разницу между традиционным файл-сервером и NAS-устройством, давайте вспомним, что традиционный файл-сервер представляет собой выделенный компьютер (сервер), на котором хранится информация, доступная пользователям сети. Для хранения информации могут использоваться жесткие диски, устанавливаемые в сервер (как правило, они устанавливаются в специальные корзины), либо к серверу могут подключаться DAS-устройства. Администрирование файл-сервера производится с использованием серверной операционной системы. Такой подход к организации систем хранения данных в настоящее время является наиболее популярным в сегменте небольших локальных сетей, однако он имеет один существенный недостаток. Дело в том, что универсальный сервер (да еще в сочетании с серверной операционной системой) - это отнюдь не дешевое решение. В то же время большинство функциональных возможностей, присущих универсальному серверу, в файл-сервере просто не используется. Идея заключается в том, чтобы создать оптимизированный файл-сервер с оптимизированной операционной системой и сбалансированной конфигурацией. Именно эту концепцию и воплощает в себе NAS-устройство. В этом смысле NAS-устройства можно рассматривать как «тонкие» файл-серверы, или, как их иначе называют, файлеры (filers).

Кроме оптимизированной ОС, освобожденной от всех функций, не связанных с обслуживанием файловой системы и реализацией ввода-вывода данных, NAS-системы имеют оптимизированную по скорости доступа файловую систему. NAS-системы проектируются таким способом, что вся их вычислительная мощь фокусируется исключительно на операциях обслуживания и хранения файлов. Сама операционная система располагается во флэш-памяти и предустанавливается фирмой-производителем. Естественно, что с выходом новой версии ОС пользователь может самостоятельно «перепрошить» систему. Подсоединение NAS-устройств к сети и их конфигурирование представляет собой достаточно простую задачу и по силам любому опытному пользователю, не говоря уже о системном администраторе.

Таким образом, в сравнении с традиционными файловыми серверами NAS-устройства являются более производительными и менее дорогими. В настоящее время практически все NAS-устройства ориентированы на использование в сетях Ethernet (Fast Ethernet, Gigabit Ethernet) на основе протоколов TCP/IP. Доступ к устройствам NAS производится с помощью специальных протоколов доступа к файлам. Наиболее распространенными протоколами файлового доступа являются протоколы CIFS, NFS и DAFS.

CIFS (Common Internet File System System - общая файловая система Интернета) - это протокол, который обеспечивает доступ к файлам и сервисам на удаленных компьютерах (в том числе и в Интернет) и использует клиент-серверную модель взаимодействия. Клиент создает запрос к серверу на доступ к файлам, сервер выполняет запрос клиента и возвращает результат своей работы. Протокол CIFS традиционно используется в локальных сетях с ОС Windows для доступа к файлам. Для транспортировки данных CIFS использует TCP/IP-протокол. CIFS обеспечивает функциональность, похожую на FTP (File Transfer Protocol), но предоставляет клиентам улучшенный контроль над файлами. Он также позволяет разделять доступ к файлам между клиентами, используя блокирование и автоматическое восстановление связи с сервером в случае сбоя сети.

Протокол NFS (Network File System - сетевая файловая система) традиционно применяется на платформах UNIX и представляет собой совокупность распределенной файловой системы и сетевого протокола. В протоколе NFS также используется клиент-серверная модель взаимодействия. Протокол NFS обеспечивает доступ к файлам на удаленном хосте (сервере) так, как если бы они находились на компьютере пользователя. Для транспортировки данных NFS использует протокол TCP/IP. Для работы NFS в Интернeте был разработан протокол WebNFS.

Протокол DAFS (Direct Access File System - прямой доступ к файловой системе) - это стандартный протокол файлового доступа, который основан на NFS. Данный протокол позволяет прикладным задачам передавать данные в обход операционной системы и ее буферного пространства напрямую к транспортным ресурсам. Протокол DAFS обеспечивает высокие скорости файлового ввода-вывода и снижает загрузку процессора благодаря значительному уменьшению количества операций и прерываний, которые обычно необходимы при обработке сетевых протоколов.

DAFS проектировался с ориентацией на использование в кластерном и серверном окружении для баз данных и разнообразных Интернет-приложений, ориентированных на непрерывную работу. Он обеспечивает наименьшие задержки доступа к общим файловым ресурсам и данным, а также поддерживает интеллектуальные механизмы восстановления работоспособности системы и данных, что делает его привлекательным для использования в NAS-системах.

Резюмируя вышеизложенное, NAS-системы можно рекомендовать для использования в мультиплатформенных сетях в случае, когда требуется сетевой доступ к файлам и достаточно важными факторами являются простота установки администрирования системы хранения данных. Прекрасным примером является применение NAS в качестве файл-сервера в офисе небольшой компании.

Storage Area Network (SAN)

Собственно, SAN - это уже не отдельное устройство, а комплексное решение, представляющее собой специализированную сетевую инфраструктуру для хранения данных. Сети хранения данных интегрируются в виде отдельных специализированных подсетей в состав локальной (LAN) или глобальной (WAN) сети.

По сути, SAN-сети связывают один или несколько серверов (SAN-серверов) с одним или несколькими устройствами хранения данных. SAN-сети позволяют любому SAN-серверу получать доступ к любому устройству хранения данных, не загружая при этом ни другие серверы, ни локальную сеть. Кроме того, возможен обмен данными между устройствами хранения данных без участия серверов. Фактически SAN-сети позволяют очень большому числу пользователей хранить информацию в одном месте (с быстрым централизованным доступом) и совместно использовать ее. В качестве устройств хранения данных могут использоваться RAID-массивы, различные библиотеки (ленточные, магнитооптические и др.), а также JBOD-системы (массивы дисков, не объединенные в RAID).

Сети хранения данных начали интенсивно развиваться и внедряться лишь с 1999 года.

Подобно тому как локальные сети в принципе могут строиться на основе различных технологий и стандартов, для построения сетей SAN также могут применяться различные технологии. Но точно так же, как стандарт Ethernet (Fast Ethernet, Gigabit Ethernet) стал стандартом де-факто для локальный сетей, в сетях хранения данных доминирует стандарт Fibre Channel (FC). Собственно, именно развитие стандарта Fibre Channel привело к развитию самой концепции SAN. В то же время необходимо отметить, что все большую популярность приобретает стандарт iSCSI, на основе которого тоже возможно построение SAN-сетей.

Наряду со скоростными параметрами одним из важнейших преимуществ Fibre Channel является возможность работы на больших расстояниях и гибкость топологии. Концепция построения топологии сети хранения данных базируется на тех же принципах, что и традиционные локальные сети на основе коммутаторов и маршрутизаторов, что значительно упрощает построение многоузловых конфигураций систем.

Стоит отметить, что для передачи данных в стандарте Fibre Channel используются как оптоволоконные, так и медные кабели. При организации доступа к территориально удаленным узлам на расстоянии до 10 км используется стандартная аппаратура и одномодовое оптоволокно для передачи сигнала. Если же узлы разнесены на большее расстояние (десятки или даже сотни километров), применяются специальные усилители.

Топология SAN-сети

Типичный вариант SAN-сети на основе стандарта Fibre Channel показан на рис. 3. Инфраструктуру такой SAN-сети составляют устройства хранения данных с интерфейсом Fibre Channel, SAN-серверы (серверы, подключаемые как к локальной сети по интерфейсу Ethernet, так и к SAN-сети по интерфейсу Fiber Channel) и коммутационная фабрика (Fibre Channel Fabric), которая строится на основе Fibre Channel-коммутаторов (концентраторов) и оптимизирована для передачи больших блоков данных. Доступ сетевых пользователей к системе хранения данных реализуется через SAN-серверы. При этом важно, что трафик внутри SAN-сети отделен от IP-трафика локальной сети, что, безусловно, позволяет снизить загрузку локальной сети.

Рис. 3. Типичная схема SAN-сети

Преимущества SAN-сетей

К основным преимуществам технологии SAN можно отнести высокую производительность, высокий уровень доступности данных, отличную масштабируемость и управляемость, возможность консолидации и виртуализации данных.

Коммутационные фабрики Fiber Channel с неблокирующей архитектурой позволяют реализовать одновременный доступ множества SAN-серверов к устройствам хранения данных.

В архитектуре SAN данные могут легко перемещаться с одного устройства хранения данных на другое, что позволяет оптимизировать размещение данных. Это особенно важно в том случае, когда нескольким SAN-серверам требуется одновременный доступ к одним и тем же устройствам хранения данных. Отметим, что процесс консолидации данных невозможен в случае использования других технологий, как, например, при применении DAS-устройств, то есть устройств хранения данных, непосредственно подсоединяемых к серверам.

Другая возможность, предоставляемая архитектурой SAN, - это виртуализация данных. Идея виртуализации заключается в том, чтобы обеспечить SAN-серверам доступ не к отдельным устройствам хранения данных, а к ресурсам. То есть серверы должны «видеть» не устройства хранения данных, а виртуальные ресурсы. Для практической реализации виртуализации между SAN-серверами и дисковыми устройствами может размещаться специальное устройство виртуализации, к которому с одной стороны подключаются устройства хранения данных, а с другой - SAN-серверы. Кроме того, многие современные FC-коммутаторы и HBA-адаптеры предоставляют возможность реализации виртуализации.

Следующая возможность, предоставляемая SAN-сетями, - это реализация удаленного зеркалирования данных. Принцип зеркалирования данных заключается в дублировании информации на несколько носителей, что повышает надежность хранения информации. Примером простейшего случая зеркалирования данных может служить объединение двух дисков в RAID-массив уровня 1. В данном случае одна и та же информация записывается одновременно на два диска. Недостатком такого способа можно считать локальное расположение обоих дисков (как правило, диски находятся в одной и той же корзине или стойке). Сети хранения данных позволяют преодолеть этот недостаток и предоставляют возможность организации зеркалирования не просто отдельных устройств хранения данных, а самих SAN-сетей, которые могут быть удалены друг от друга на сотни километров.

Еще одно преимущество SAN-сетей заключается в простоте организации резервного копирования данных. Традиционная технология резервного копирования, которая используется в большинстве локальных сетей, требует выделенного Backup-сервера и, что особенно важно, выделенной полосы пропускания сети. Фактически во время операции резервного копирования сам сервер становится недоступным для пользователей локальной сети. Собственно, именно поэтому резервное копирование производится, как правило, в ночное время.

Архитектура сетей хранения данных позволяет принципиально по-иному подойти к проблеме резервного копирования. В этом случае Backup-сервер является составной частью SAN-сети и подключается непосредственно к коммутационной фабрике. В этом случае Backup-трафик оказывается изолированным от трафика локальной сети.

Оборудование, используемое для создания SAN-сетей

Как уже отмечалось, для развертывания SAN-сети требуются устройства хранения данных, SAN-серверы и оборудование для построения коммутационной фабрики. Коммутационные фабрики включают как устройства физического уровня (кабели, коннекторы), так и устройства подключения (Interconnect Device) для связи узлов SAN друг с другом, устройства трансляции (Translation devices), выполняющие функции преобразования протокола Fibre Channel (FC) в другие протоколы, например SCSI, FCP, FICON, Ethernet, ATM или SONET.

Кабели

Как уже отмечалось, для соединения SAN-устройств стандарт Fibre Channel допускает использование как волоконно-оптических, так и медных кабелей. При этом в одной SAN-сети могут применяться различные типы кабелей. Медный кабель используется для коротких расстояний (до 30 м), а волоконно-оптический - как для коротких, так и для расстояний до 10 км и больше. Применяют как многомодовый (Multimode), так и одномодовый (Singlemode) волоконно-оптические кабели, причем многомодовый используется для расстояний до 2 км, а одномодовый - для больших расстояний.

Сосуществование различных типов кабелей в пределах одной SAN-сети обеспечивается посредством специальных конверторов интерфейсов GBIC (Gigabit Interface Converter) и MIA (Media Interface Adapter).

В стандарте Fibre Channel предусмотрено несколько возможных скоростей передачи (см. таблицу). Отметим, что в настоящее время наиболее распространены FC-устройства стандартов 1, 2 и 4 GFC. При этом обеспечивается обратная совместимость более скоростных устройств с менее скоростными, то есть устройство стандарта 4 GFC автоматически поддерживает подключение устройств стандартов 1 и 2 GFC.

Устройства подключения (Interconnect Device)

В стандарте Fibre Channel допускается использование различных сетевых топологий подключения устройств, таких как «точка-точка» (Point-to-Point), кольцо с разделяемым доступом (Arbitrated Loop, FC-AL) и коммутируемая связная архитектура (switched fabric).

Топология «точка-точка» может применяться для подключения сервера к выделенной системе хранения данных. В этом случае данные не используются совместно с серверами SAN-сети. Фактически данная топология является вариантом DAS-системы.

Для реализации топологии «точка-точка», как минимум, необходим сервер, оснащенный адаптером Fibre Channel, и устройство хранения данных с интерфейсом Fibre Channel.

Топология кольца с разделенным доступом (FC-AL) подразумевает схему подключения устройств, при котором данные передаются по логически замкнутому контуру. При топологии кольца FC-AL в качестве устройств подключения могут выступать концентраторы или коммутаторы Fibre Channel. При использовании концентраторов полоса пропускания делится между всеми узлами кольца, в то время как каждый порт коммутатора предоставляет протокольную полосу пропускания для каждого узла.

На рис. 4 показан пример кольца Fibre Channel с разделением доступа.

Рис. 4. Пример кольца Fibre Channel с разделением доступа

Конфигурация аналогична физической звезде и логическому кольцу, используемым в локальных сетях на базе технологии Token Ring. Кроме того, как и в сетях Token Ring, данные перемещаются по кольцу в одном направлении, но, в отличие от сетей Token Ring, устройство может запросить право на передачу данных, а не ждать получения пустого маркера от коммутатора. Кольца Fibre Channel с разделением доступа могут адресовать до 127 портов, однако, как показывает практика, типичные кольца FC-AL содержат до 12 узлов, а после подключения 50 узлов производительность катастрофически снижается.

Топология коммутируемой связной архитектуры (Fibre Channel switched-fabric) реализуется на базе Fibre Channel-коммутаторов. В данной топологии каждое устройство имеет логическое подключение к любому другому устройству. Фактически Fibre Channel-коммутаторы связной архитектуры выполняют те же функции, что и традиционные Ethernet-коммутаторы. Напомним, что, в отличие от концентратора, коммутатор - это высокоскоростное устройство, которое обеспечивает подключение по схеме «каждый с каждым» и обрабатывает несколько одновременных подключений. Любой узел, подключенный к Fibre Channel-коммутатору, получает протокольную полосу пропускания.

В большинстве случаев при создании крупных SAN-сетей используется смешанная топология. На нижнем уровне применяются FC-AL-кольца, подключенные к малопроизводительным коммутаторам, которые, в свою очередь, подключаются к высокоскоростным коммутаторам, обеспечивающим максимально возможную пропускную способность. Несколько коммутаторов могут быть соединены друг с другом.

Устройства трансляции

Устройства трансляции являются промежуточными устройствами, выполняющими преобразование протокола Fibre Channel в протоколы более высоких уровней. Эти устройства предназначены для соединения Fibre Channel-сети с внешней WAN-сетью, локальной сетью, а также для присоединения к Fibre Channel-сети различных устройств и серверов. К таким устройствам относятся мосты (Bridge), Fibre Channel-адаптеры (Host Bus Adapters (HBA), маршрутизаторы, шлюзы и сетевые адаптеры. Классификация устройств трансляции показана на рис. 5.

Рис. 5. Классификация устройств трансляции

Наиболее распространенными устройствами трансляции являются HBA-адаптеры с интерфейсом PCI, которые применяются для подключения серверов к сети Fibre Channel. Сетевые адаптеры позволяют подключать локальные Ethernet-сети к сетям Fibre Channel. Мосты используются для подключения устройств хранения данных с SCSI интерфейсом к сети на базе Fibre Channel. Cледует отметить, что в последнее время практически все устройства хранения данных, которые предназначены для применения в SAN, имеют встроенный Fibre Channel и не требуют использования мостов.

Устройства хранения данных

В качестве устройств хранения данных в SAN-сетях могут использоваться как жесткие диски, так и ленточные накопители. Если говорить о возможных конфигурациях применения жестких дисков в качестве устройств хранения данных в SAN-сетях, то это могут быть как массивы JBOD, так и RAID-массивы дисков. Традиционно устройства хранения данных для SAN-сетей выпускаются в виде внешних стоек или корзин, оснащенных специализированным RAID-контроллером. В отличие от NAS- или DAS-устройств, устройства для SAN-систем оснащаются Fibre Channel-интерфейсом. При этом сами диски могут иметь как SCSI-, так и SATA-интерфейс.

Кроме устройств хранения на основе жестких дисков, в SAN-сетях широкое применение находят ленточные накопители и библиотеки.

SAN-серверы

Серверы для сетей SAN отличаются от обычных серверов приложений только одной деталью. Кроме сетевого Ethernet-адаптера, для взаимодействия сервера с локальной сетью они оснащаются HBA-адаптером, что позволяет подключать их к SAN-сетям на основе Fibre Channel.

Системы хранения данных компании Intel

Далее мы рассмотрим несколько конкретных примеров устройств хранения данных компании Intel. Строго говоря, компания Intel не выпускает законченных решений и занимается разработкой и производством платформ и отдельных компонентов для построения систем хранения данных. На основе данных платформ многие компании (в том числе и целый ряд российских компаний) производят уже законченные решения и продают их под своими логотипами.

Intel Entry Storage System SS4000-E

Система хранения данных Intel Entry Storage System SS4000-E представляет собой NAS-устройство, предназначенное для применения в небольших и средних офисах и многоплатформенных локальных сетях. При использовании системы Intel Entry Storage System SS4000-E разделяемый сетевой доступ к данным получают клиенты на основе Windows-, Linux- и Macintosh-платформ. Кроме того, Intel Entry Storage System SS4000-E может выступать как в роли DHCP-сервера, так и DHCP-клиента.

Система хранения данных Intel Entry Storage System SS4000-E представляет собой компактную внешнюю стойку с возможностью установки до четырех дисков с интерфейсом SATA (рис. 6). Таким образом, максимальная емкость системы может составлять 2 Тбайт при использовании дисков емкостью 500 Гбайт.

Рис. 6. Система хранения данных Intel Entry Storage System SS4000-E

В системе Intel Entry Storage System SS4000-E применяется SATA RAID-контроллер с поддержкой уровней RAID-массивов 1, 5 и 10. Поскольку данная система является NAS-устройством, то есть фактически «тонким» файл-сервером, система хранения данных должна иметь специализированный процессор, память и прошитую операционную систему. В качестве процессора в системе Intel Entry Storage System SS4000-E применяется Intel 80219 с тактовой частотой 400 МГц. Кроме того, система оснащена 256 Мбайт памяти DDR и 32 Мбайт флэш-памяти для хранения операционной системы. В качестве операционной системы используется Linux Kernel 2.6.

Для подключения к локальной сети в системе предусмотрен двухканальный гигабитный сетевой контроллер. Кроме того, имеются также два порта USB.

Устройство хранения данных Intel Entry Storage System SS4000-E поддерживает протоколы CIFS/SMB, NFS и FTP, а настройка устройства реализуется с использованием web-интерфейса.

В случае применения Windows-клиентов (поддерживаются ОС Windows 2000/2003/XP) дополнительно имеется возможность реализации резервного копирования и восстановления данных.

Intel Storage System SSR212CC

Система Intel Storage System SSR212CC представляет собой универсальную платформу для создания систем хранения данных типа DAS, NAS и SAN. Эта система выполнена в корпусе высотой 2 U и предназначена для монтажа в стандартную 19-дюймовую стойку (рис. 7). Система Intel Storage System SSR212CC поддерживает установку до 12 дисков с интерфейсом SATA или SATA II (поддерживается функция горячей замены), что позволяет наращивать емкость системы до 6 Тбайт при использовании дисков емкостью по 550 Гбайт.

Рис. 7. Система хранения данных Intel Storage System SSR212CC

Фактически система Intel Storage System SSR212CC представляет собой полноценный высокопроизводительный сервер, функционирующий под управлением операционных систем Red Hat Enterprise Linux 4.0, Microsoft Windows Storage Server 2003, Microsoft Windows Server 2003 Enterprise Edition и Microsoft Windows Server 2003 Standard Edition.

Основу сервера составляет процессор Intel Xeon с тактовой частотой 2,8 ГГц (частота FSB 800 МГц, размер L2-кэша 1 Мбайт). Система поддерживает использование памяти SDRAM DDR2-400 с ECC максимальным объемом до 12 Гбайт (для установки модулей памяти предусмотрено шесть DIMM-слотов).

Система Intel Storage System SSR212CC оснащена двумя RAID-контроллерами Intel RAID Controller SRCS28Xs с возможностью создания RAID-массивов уровней 0, 1, 10, 5 и 50. Кроме того, система Intel Storage System SSR212CC имеет двухканальный гигабитный сетевой контроллер.

Intel Storage System SSR212MA

Система Intel Storage System SSR212MA представляет собой платформу для создания систем хранения данных в IP SAN-сетях на основе iSCSI.

Данная система выполнена в корпусе высотой 2 U и предназначена для монтажа в стандартную 19-дюймовую стойку. Система Intel Storage System SSR212MA поддерживает установку до 12 дисков с интерфейсом SATA (поддерживается функция горячей замены), что позволяет наращивать емкость системы до 6 Тбайт при использовании дисков емкостью по 550 Гбайт.

По своей аппаратной конфигурации система Intel Storage System SSR212MA не отличается от системы Intel Storage System SSR212CC.

Система хранения данных (СХД) - это конгломерат специализированного оборудования и программного обеспечения , который предназначен для хранения и передачи больших массивов информации. Позволяет организовать хранение информации на дисковых площадках с оптимальным распределением ресурсов.

Еще один фактор - появление на рынке множества компаний, которые предлагают свои решения для поддержки бизнеса предприятий: ERP , биллинговые системы , системы поддержки принятия решений и т. д. Все они позволяют собирать детальные данные самого разного характера в огромных объемах. При наличии в организации развитой ИТ-инфраструктуры эти данные можно собрать вместе и проанализировать их.

Следующий фактор - технологического характера. До некоторого времени производители приложений самостоятельно разрабатывали разные версии своих решений для разных серверных платформ или предлагали открытые решения. Важной для отрасли технологической тенденцией стало создание адаптируемых платформ для решения различных аналитических задач, которые включают аппаратную составляющую и СУБД . Пользователей уже не волнует, кто сделал для их компьютера процессор или оперативную память, - они рассматривают хранилище данных как некую услугу. И это важнейший сдвиг в сознании.

Технологии, которые позволяют использовать хранилища данных для оптимизации операционных бизнес-процессов практически в реальном времени не только для высококвалифицированных аналитиков и топ-менеджеров, но и для сотрудников фронт-офиса, в частности для сотрудников офисов продаж и контактных центров. Принятие решений делегируется сотрудникам, стоящим на более низких ступенях корпоративной лестницы. Необходимые им отчеты, как правило, просты и кратки, но их требуется очень много, а время формирования должно быть невелико.

Сферы применения СХД

Традиционные хранилища данных можно встретить повсеместно. Они предназначены для формирования отчетности, помогающей разобраться с тем, что произошло в компании. Однако это первый шаг, базис.

Людям становится недостаточно знать, что произошло, им хочется понять, почему это случилось. Для этого используются инструменты бизнес-аналитики, которые помогают понять то, что говорят данные.

Вслед за этим приходит использование прошлого для предсказания будущего, построение прогностических моделей: какие клиенты останутся, а какие уйдут; какие продукты ждет успех, а какие окажутся неудачными и т.д.

Некоторые организации уже находятся на стадии, когда хранилища данных начинают использовать для понимания того, что происходит в бизнесе в настощее время. Поэтому следующий шаг - это «активация» фронтальных систем при помощи решений, основанных на анализе данных, зачастую в автоматическом режиме.

Объемы цифровой информации растут лавинообразно. В корпоративном секторе этот рост вызван, с одной стороны, ужесточением регулирования и требованием сохранять все больше информации, относящейся к ведению бизнеса. С другой стороны, ужесточение конкуренции требует все более точной и подробной информации о рынке, клиентах, их предпочтениях, заказах, действиях конкурентов и т.д .

В государственном секторе рост объемов хранимых данных поддерживает повсеместный переход к межведомственному электронному документообороту и создание ведомственных аналитических ресурсов, основой которых являются разнообразные первичные данные.

Не менее мощную волну создают и обычные пользователи, которые выкладывают в интернет свои фотографии, видеоролики и активно обмениваются мультимедийным контентом в социальных сетях.

Требования к СХД

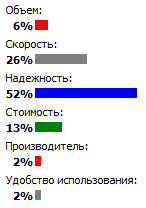

Какой критерий выбора дисковых СХД для Вас важнее? Результат опроса на сайте www.timcompany.ru, февраль 2012 года

Группа компаний ТИМ в 2008 году провела опрос среди клиентов с целью выяснить, какие характеристики наиболее важны для них при выборе СХД . На первых позициях оказались качество и функциональность предлагаемого решения. В то же время расчет совокупной стоимости владения для российского потребителя явление нетипичное. Заказчики чаще всего не до конца осознают какие их ожидают издержки, например, затраты на аренду и оснащение помещения, электроэнергию, кондиционирование, обучение и зарплату квалифицированного персонала и проч.

Когда возникает необходимость приобрести СХД, максимум, что оценивает для себя покупатель, это прямые затраты, проходящие через бухгалтерию на приобретение данного оборудования. Впрочем, цена по степени важности оказалась на девятом месте из десяти. Безусловно, заказчики учитывают возможные трудности, связанные с обслуживанием техники. Обычно их избежать помогают пакеты расширенной гарантийной поддержки, которые обычно предлагают в проектах.

Надёжность и отказоустойчивость. В СХД предусмотрено полное или частичное резервирование всех компонент – блоков питания, путей доступа, процессорных модулей, дисков, кэша и т.д. Обязательно наличие системы мониторинга и оповещения о возможных и существующих проблемах.

Доступность данных. Обеспечивается продуманными функциями сохранения целостности данных (использование технологии RAID, создание полных и мгновенных копий данных внутри дисковой стойки, реплицирование данных на удаленную СХД и т.д.) и возможностью добавления (обновления) аппаратуры и программного обеспечения в горячем режиме без остановки комплекса;

Средства управления и контроля. Управление СХД осуществляется через web-интерфейс или командную строку, есть функции мониторинга и несколько вариантов оповещения администратора о неполадках. Доступны аппаратные технологии диагностики производительности.

Производительность. Определяется числом и типом накопителей, объёмом кэш-памяти, вычислительной мощностью процессорной подсистемы, числом и типом внутренних и внешних интерфейсов, а также возможностями гибкой настройки и конфигурирования.

Масштабируемость. В СХД обычно присутствует возможность наращивания числа жёстких дисков, объёма кэш-памяти, аппаратной модернизации и расширения функционала с помощью специального ПО. Все перечисленные операции производят без значительного переконфигурирования и потерь функциональности, что позволяет экономить и гибко подходить к проектированию ИТ-инфраструктуры.

Типы СХД

Дисковые СХД

Используют для оперативной работы с данными, а также для создания промежуточных резервных копий.

Существуют следующие виды дисковых СХД :

- СХД для рабочих данных (высокопроизводительное оборудование);

- СХД для резервных копий (дисковые библиотеки);

- СХД для долговременного хранения архивов (системы CAS).

Ленточные СХД

Предназначены для создания резервных копий и архивов.

Существуют следующие виды ленточных СХД:

- отдельные накопители;

- автозагрузчики (один накопитель и несколько слотов для лент);

- ленточные библиотеки (более одного накопителя, множество слотов для лент).

Варианты подключений СХД

Для подключения устройств и жестких дисков внутри одного хранилища используются различные внутренние интерфейсы:

Наиболее распространенные внешние интерфейсы подключения СХД:

Популярный интерфейс межузлового кластерного взаимодействия Infiniband теперь также используется для доступа к СХД.

Варианты топологий СХД

Традиционный подход к хранилищам данных состоит в непосредственном подключении серверов к системе хранения Direct Attached Storage, DAS (Direct Attached Storage). Помимо Direct Attached Storage, DAS , существуют устройства хранения данных, подключаемые к сети, - NAS (Network Attached Storage), a также компоненты сетей хранения данных - SAN (Storage Area Networks). И NAS -, и SAN -системы появились в качестве альтернативы архитектуре Direct Attached Storage, DAS . Причем каждое решение разрабатывалось как ответ на растущие требования к системам хранения данных и основывалось на использовании доступных в то время технологиях.

Архитектуры сетевых систем хранения были разработаны в 1990-х гг., и их задачей было устранение основных недостатков систем Direct Attached Storage, DAS . В общем случае сетевые решения в области систем хранения должны были реализовать три задачи: снизить затраты и сложность управления данными, уменьшить трафик локальных сетей, повысить степень готовности данных и общую производительность. При этом архитектуры NAS и SAN решают различные аспекты общей проблемы. Результатом стало одновременное сосуществование двух сетевых архитектур, каждая из которых имеет свои преимущества и функциональные возможности.

Системы хранения прямого подключения (DAS)

Поскольку СХД неотделимы от вычислительных ресурсов, то неудивительно, что многие крупнейшие мировые производители систем хранения являются одновременно и лидерами на серверном рынке. Из перечисленных выше производителей только три занимаются исключительно СХД - это EMC , Hitachi и NetApp .

Из производителей СХД, представленных в нашей стране, отметим компании, которые относятся к упомянутому выше классу «Б».

- Cisco (Linksys)

Набирающая популярность концепция публичных облаков оказывает влияние на сегмент СХД. Владельцы публичных облаков менее склонны к выплате бренд-премии, что может открыть широкие возможности для производителей второго эшелона, нишевых или новых игроков .

Отечественные производители дисковых СХД (например, компания DEPO Computers (ДЕПО Электроникс)) собирают свои системы на базе компонентов зарубежных производителей, в том числе Microsemi (ранее Adaptec) , Chenbro , Falconstore , Intel , LSI Logic , Lustre и других. В целом же СХД местного производства поставляются преимущественно в небольшие проекты. Кроме того, важно отметить, что в сегменте СХД наблюдается стойкая тенденция к вытеснению отечественных компаний мировыми.

Важным отличием систем А-брендов от СХД местного производства является наличие у них специального ПО, предназначенного для восстановления и защиты данных, резервного копирования, удаленного управления и мониторинга, «управления жизненным циклом информации» (Information Lifecycle Management, ILM), диагностики и т.д. ПО с похожими функциями разрабатывает и множество независимых компаний, поэтому его можно приобрести отдельно. Конечно, при отсутствии проблем с совместимостью.

Стоимость СХД очень сильно зависит от функциональных возможностей и дополнительных опций – модулей расширения, типа жестких дисков, сервисного обслуживания и т.д .

Российский рынок СХД

В последние несколько лет российский рынок СХД успешно развивается и растет. Так, в конце 2010 года выручка производителей систем хранения, проданных на российском рынке, превысила $65 млн, что по сравнению со вторым кварталом того же года больше на 25% и на 59% 2009-го. Общая емкость проданных СХД составила примерно 18 тыс. терабайт, что является показателем роста больше чем на 150% в год.

Российский рынок систем хранения данных развивается чрезвычайно динамично в силу того, что он ещё очень молод. Отсутствие унаследованного оборудования не оказывает на него значительного влияния, поскольку из-за взрывного роста объемов данных старые системы попросту не отвечают требованиям клиентов и «вымываются» значительно быстрее, чем, например, древние серверы и рабочие станции.

Стремительный рост объемов данных все чаще вынуждает отечественные компании приобретать внешние дисковые системы хранения. Этому в немалой степени способствует и традиционная тенденция снижения стоимости ИТ-компонентов. Если раньше внешние СХД воспринимались только как атрибут крупных организаций, то теперь потребность в этих системах не отвергают даже небольшие компании .

Основные этапы проектов создания хранилищ данных

Хранилище данных - очень сложный объект. Одним из основных условий для его создания является наличие грамотных специалистов, понимающих, что они делают, - не только на стороне поставщика, но и на стороне клиента. Потребление СХД становится неотъемлемой частью внедрения комплексных инфраструктурных решений. Как правило, речь идет о внушительных инвестициях на 3-5 лет, и заказчики рассчитывают, что в течение всего срока эксплуатации система в полной мере будет отвечать предъявляемым со стороны бизнеса требованиям.

Далее, необходимо обладать технологиями создания хранилищ данных. Если вы начали создавать хранилище и разрабатываете для него логическую модель, то у вас должен быть словарь, определяющий все основные понятия. Даже такие расхожие понятия, как «клиент» и «продукт», имеют сотни определений. Только получив представление о том, что означают те или иные термины в данной организации, можно определить источники необходимых данных, которые следует загрузить в хранилище.

Теперь можно приступить к созданию логической модели данных. Это критически важный этап проекта. Надо от всех участников проекта создания хранилища данных добиться согласия относительно актуальности этой модели. По завершении этой работы становится понятно, что в действительности нужно клиенту. И только потом имеет смысл говорить о технологических аспектах, например о размерах хранилища. Клиент оказывается лицом к лицу с гигантской моделью данных, которая содержит тысячи атрибутов и связей.

Необходимо постоянно помнить, что хранилище данных не должно быть игрушкой для ИТ-департамента и объектом затрат для бизнеса. И в первую очередь хранилище данных должно помогать клиентам решать их самые критичные проблемы. Например, помочь телекоммуникационным компаниям предотвратить утечку клиентов. Для решения проблемы необходимо заполнить определенные фрагменты большой модели данных, и затем помогаем выбрать приложения, которые помогут решить эту проблему. Это могут быть очень несложные приложения, скажем Excel . Первым делом стоит попытаться решить основную проблему с помощью этих инструментов. Пытаться заполнить всю модель сразу, использовать все источники данных будет большой ошибкой. Данные в источниках необходимо тщательно проанализировать, чтобы обеспечить их качество. После успешного решения одной-двух проблем первостепенной важности, в ходе которого обеспечено качество необходимых для этого источников данных, можно приступать к решению следующих проблем, постепенно заполняя другие фрагменты модели данных, а также используя заполненные ранее фрагменты.

В каталоге TAdviser перечислен ряд российских компаний, имеющих отношение к поставкам и внедрению СХД и предоставлению сопутствующих услуг. Одновременно стоит понимать, что в ряде крупных проектов некоторые вендоры могут участвовать напрямую, в первую очередь, НР и IBM . Некоторые заказчики в этом случае чувствуют себя увереннее, всецело полагаясь на сервисную поддержку ведущих мировых производителей. Безусловно, стоимость владения в этом случае заметно повышается.

Тенденции и перспективы

Стремительная эволюция ежегодно вносит серьезные изменения в основные тренды развития СХД. Так, в 2009 году во главу угла ставилась способность экономично распределять ресурсы (Thin Provisioning), последние несколько лет проходят под знаком работы СХД в "облаках". Спектр предлагаемых систем отличается разнообразием: огромное количество представленных моделей, различные варианты и комбинации решений от начального уровня до Hi-End класса, решения под ключ и покомпонентная сборка с применением самой современной начинки, программно-аппаратные решения от российских производителей.

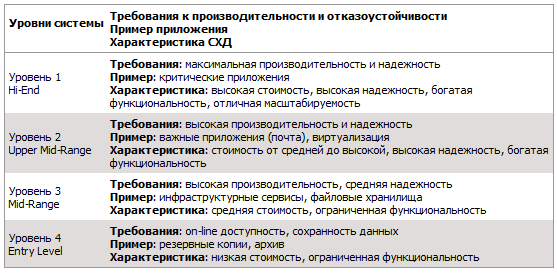

Стремление к сокращению расходов на ИТ-инфраструктуру требует постоянного баланса между стоимостью ресурсов СХД и ценностью данных, которые на них хранятся в данный момент времени. Для принятия решения о том, как наиболее эффективно размещать ресурсы на программных и аппаратных средствах, специалисты ЦОД руководствуются не только подходами ILM и DLM, но и практикой многоуровнего хранения данных. Каждой единице информации, подлежащей обработке и хранению, присваиваются определенные метрики. В их числе степень доступности (скорость предоставления информации), важность (стоимость потери данных в случае аппаратного и программного сбоя), период, через который информация переходит на следующую стадию.

Пример разделения систем хранения в соответствии с требованиями к хранению и обработке информации по методике многоуровневого хранения данных.

Пример разделения систем хранения в соответствии с требованиями к хранению и обработке информации по методике многоуровневого хранения данных.

Вместе с тем, возросли требования к производительности транзакционных систем, что предполагает увеличение количества дисков в системе и соответственно выбор СХД более высокого класса. В ответ на этот вызов производители снабдили системы хранения новыми твердотельными дисками, превосходящими прежние по производительности более чем в 500 раз на “коротких” операциях чтения-записи (характерных для транзакционных систем).

Популяризация облачной парадигмы способствовала повышению требований к производительности и надежности СХД, поскольку в случае отказа или потери данных пострадают не один-два подключенных напрямую сервера - произойдет отказ в обслуживании для всех пользователей облака. В силу той же парадигмы проявилась тенденция к объединению устройств разных производителей в федерацию. Она создает объединенный пул ресурсов, которые предоставляются по требованию с возможностью динамического перемещения приложений и данных между географически разнесенными площадками и поставщиками услуг.

Определенный сдвиг отмечен в 2011 году в области управления “Большими данными” . Раньше подобные проекты находись на стадии обсуждения, а теперь они перешли в стадию реализации, пройдя весь путь от продажи до внедрения.

На рынке намечается прорыв, который уже случился на рынке серверов, и, возможно, уже в 2012 году мы увидим в массовом сегменте СХД, поддерживающие дедупликацию и технологию Over Subscribing . В итоге, как и в случае серверной виртуализации, это обеспечит масштабную утилизацию емкости СХД.

Дальнейшее развитие оптимизации хранения будет заключаться в совершенствовании методов сжатия данных. Для неструктурированных данных, на которые приходится 80% всего объема, коэффициент сжатия может достигать нескольких порядков. Это позволит существенно снизить удельную стоимость хранения данных для современных SSD

SAS, NAS, SAN: шаг к сетям хранения данных

Вступление

С повседневным усложнением сетевых компьютерных систем и глобальных корпоративных решений мир начал требовать технологий, которые бы дали толчок к возрождению корпоративных систем хранения информации (сторедж-систем). И вот, одна единая технология приносит в мировую сокровищницу достижений в области сторедж невиданное ранее быстродействие, колоссальные возможности масштабирования и исключительные преимущества общей стоимости владения. Обстоятельства, которые сформировались с появлением стандарта FC-AL (Fibre Channel — Arbitrated Loop) и SAN (Storage Area Network), которая развивается на его основе, обещают революцию в дата-ориентированных технологиях компьютинга.

«The most significant development in storage we"ve seen in 15 years»

Data Communications International, March 21, 1998

Формальное определение SAN в трактовке Storage Network Industry Association (SNIA):

«Сеть, главной задачей которой является передача данных между компьютерными системами и устройствами хранения данных, а также между самими сторедж-системами. SAN состоит из коммуникационной инфраструктуры, которая обеспечивает физическую связь, а также отвечает за уровень управления (management layer), который объединяет связи, сторедж и компьютерные системы, осуществляя передачу данных безопасно и надежно».

SNIA Technical Dictionary, copyright Storage Network Industry Association, 2000

Варианты организации доступа к сторедж-системам

Различают три основных варианта организации доступа к системам хранения:

- SAS (Server Attached Storage), сторедж, присоединенный к серверу;

- NAS (Network Attached Storage), сторедж, подсоединенный к сети;

- SAN (Storage Area Network), сеть хранения данных.

Рассмотрим топологии соответствующих сторедж-систем и их особенности.

SAS

Сторедж-система, присоединенная к серверу. Знакомый всем, традиционный способ подключения системы хранения данных к высокоскоростному интерфейсу в сервере, как правило, к параллельному SCSI интерфейсу.

Рисунок 1. Server Attached Storage

Использование отдельного корпуса для сторедж-системы в рамках топологии SAS не является обязательным.

Основное преимущество сторедж, подсоединенного к серверу, в сравнении с другими вариантами — низкая цена и высокое быстродействие из расчета один сторедж для одного сервера. Такая топология является самой оптимальной в случае использования одного сервера, через который организуется доступ к массиву данных. Но у нее остается ряд проблем, которые побудили проектировщиков искать другие варианты организации доступа к системам хранения данных.

К особенностям SAS можно отнести:

- Доступ к данных зависит от ОС и файловой системы (в общем случае);

- Сложность организации систем с высокой готовностью;

- Низкая стоимость;

- Высокое быстродействие в рамках одной ноды;

- Уменьшение скорости отклика при загрузке сервера, который обслуживает сторедж.

NAS

Сторедж-система, подсоединенная к сети. Этот вариант организации доступа появился сравнительно недавно. Основным его преимуществом является удобство интеграции дополнительной системы хранения данных в существующие сети, но сам по себе он не привносит сколь-нибудь радикальных улучшений в архитектуру сторедж. Фактически NAS есть чистый файл-сервер, и сегодня можно встретить немало новых реализаций сторедж типа NAS на основе технологии тонкого сервера (Thin Server).

Рисунок 2. Network Attached Storage.

Особенности NAS:

- Выделенный файл-сервер;

- Доступ к данным не зависит от ОС и платформы;

- Удобство администрирования;

- Максимальная простота установки;

- Низкая масштабируемость;

- Конфликт с трафиком LAN/WAN.

Сторедж, построенный по технологии NAS, является идеальным вариантом для дешевых серверов с минимальным набором функций.

SAN

Сети хранения данных начали интенсивно развиваться и внедряться лишь с 1999 года. Основой SAN является отдельная от LAN/WAN сеть, которая служит для организации доступа к данным серверов и рабочих станций, занимающихся их прямой обработкой. Такая сеть создается на основе стандарта Fibre Channel, что дает сторедж-системам преимущества технологий LAN/WAN и возможности по организации стандартных платформ для систем с высокой готовностью и высокой интенсивностью запросов. Почти единственным недостатком SAN на сегодня остается относительно высокая цена компонент, но при этом общая стоимость владения для корпоративных систем, построенных с использованием технологии сетей хранения данных, является довольно низкой.

Рисунок 3. Storage Area Network.

К основным преимуществам SAN можно отнести практически все ее особенности:

- Независимость топологии SAN от сторедж-систем и серверов;

- Удобное централизованное управление;

- Отсутствие конфликта с трафиком LAN/WAN;

- Удобное резервирование данных без загрузки локальной сети и серверов;

- Высокое быстродействие;

- Высокая масштабируемость;

- Высокая гибкость;

- Высокая готовность и отказоустойчивость.

Следует также заметить, что технология эта еще довольно молодая и в ближайшее время она должна пережить немало усовершенствований в области стандартизации управления и способов взаимодействия SAN подсетей. Но можно надеяться, что это угрожает пионерам лишь дополнительными перспективами первенства.

FC как основа построения SAN

Подобно LAN, SAN может создаваться с использованием различных топологий и носителей. При построении SAN может использоваться как параллельный SCSI интерфейс, так и Fibre Channel или, скажем, SCI (Scalable Coherent Interface), но своей все возрастающей популярностью SAN обязана именно Fibre Channel. В проектировании этого интерфейса принимали участие специалисты со значительным опытом в разработке как канальных, так и сетевых интерфейсов, и им удалось объединить все важные положительные черты обеих технологий для того, чтобы получить что-то в самом деле революционно новое. Что именно?

Основные ключевые особенности канальных:

- Низкие задержки

- Высокие скорости

- Высокая надежность

- Топология точка-точка

- Небольшие расстояния между нодами

- Зависимость от платформы

- Многоточечные топологии

- Большие расстояния

- Высокая масштабируемость

- Низкие скорости

- Большие задержки

- Высокие скорости

- Независимость от протокола (0-3 уровни)

- Большие расстояния

- Низкие задержки

- Высокая надежность

- Высокая масштабируемость

- Многоточечные топологии

Традиционно сторедж интерфейсы (то, что находится между хостом и устройствами хранения информации) были преградой на пути к росту быстродействия и увеличению объема систем хранения данных. В то же время прикладные задачи требуют значительного прироста аппаратных мощностей, которые, в свою очередь, тянут за собой потребность в увеличении пропускной способности интерфейсов для связи со сторедж-системами. Именно проблемы построения гибкого высокоскоростного доступа к данным помогает решить Fibre Channel.

Стандарт Fibre Channel был окончательно определен за последние несколько лет (с 1997-го по 1999-й), на протяжении которых была проведена колоссальная работа по согласованию взаимодействия производителей различных компонент, и было сделано все необходимое, чтобы Fibre Channel превратился из чисто концептуальной технологии в реальную, которая получила поддержку в виде инсталляций в лабораториях и вычислительных центрах. В году 1997 были спроектированы первые коммерческие образцы краеугольных компонент для построения SAN на базе FC, таких как адаптеры, хабы, свичи и мосты. Таким образом, уже начиная с 1998-го года FC используется в коммерческих целях в деловой сфере, на производстве и в масштабных проектах реализации систем, критичных к отказам.